Gazeta Wyborcza (Varsovie)

Οct. 11, 2021

GAZETA WYBORCZA. – Unique agence de l’UE à avoir son siège à Varsovie, l’agence Frontex de garde-frontières et de gardes-côtes est devenue ces dernières années le premier corps européen en uniforme, avec un budget et un accès aux technologies de plus en plus importants. Que fait-elle de ces moyens ?

PETRA MOLNAR. – Elle recourt à de très nombreuses solutions : des robots avancés à l’automatisation de contrôles aux frontières en passant par des drones et des expérimentations fondées sur l’intelligence artificielle. Ainsi, depuis plusieurs années, elle teste des drones et des zeppelins autonomes pour surveiller la mer Égée et détecter les embarcations de migrants. Frontex a également commandé au think tank américain RAND Corporation un rapport qui explique comment, sur la base de données spatiales, l’intelligence artificielle et les algorithmes peuvent par exemple produire des analyses prédictives avancées qui montrent par où des gens peuvent tenter de traverser les frontières.

Toutefois, l’aspect le plus inquiétant du fonctionnement de Frontex est que, selon des témoignages très fiables, ses agents sont engagés dans le refoulement de réfugiés, notamment vers la Turquie et la Libye, alors que cela est contraire au droit international. Les technologies de surveillance que l’Europe déploie massivement à ses frontières facilitent de telles actions.

Il y a également le projet européen Roborder, dont le but est de créer “un système pleinement autonome de surveillance des frontières” avec des robots terrestres, aériens et marins.

Il aura pour conséquence une augmentation du nombre de morts aux frontières. L’UE n’est pas seule à tester drones et robots pour surveiller ses frontières : aux États-Unis, le Service des douanes et de la protection des frontières a noué un partenariat avec la société Anduril Industries afin de construire à la frontière avec le Mexique un mur virtuel composé de tours d’observation et de drones. Bien que les responsables politiques américains présentent ces frontières “intelligentes” comme une alternative plus “humanitaire” au mur physique prévu par Donald Trump, le contrôle de plus en plus étroit effectué à l’aide de nouvelles technologies de surveillance a conduit au doublement du nombre de morts d’immigrants tentant d’entrer aux États-Unis, car il les a forcés à emprunter des routes migratoires plus dangereuses dans les déserts de l’Arizona. Il a ainsi créé ce que l’anthropologue Jason De León appelle la “terre des tombeaux ouverts” [The Land of Open Graves, ouvrage non traduit en français].

Nous avons la même chose en Europe, mais en mer.

L’Organisation internationale pour les migrations indique que, depuis 2014, plus de 20 000 personnes ont trouvé la mort dans des naufrages le long des frontières de l’UE. Or en mettant l’accent sur la sécurité et le respect des frontières, le nouveau “pacte sur la migration et l’asile” proposé par la Commission européenne envoie un signal clair : il est possible de sacrifier des vies humaines pour protéger le territoire de l’UE.

Dans les aéroports de Lituanie, de Hongrie et de Grèce, le programme iBorderCtrl a testé l’intelligence artificielle dans le but de détecter des mensonges. Le système posait des questions aux passagers et scannait les micro-expressions de leur visage. En cas de doute, il les orientait vers des contrôles plus poussés.

Il est incroyable que ce projet ait reçu un financement européen. Même si les expérimentations de ce type sont justifiées par l’argument selon lequel ce ne sont que des tests, pensons-nous à leurs conséquences potentielles ?

Lesquelles ?

Nous savons que même les polygraphes classiques ne sont pas fiables, et leurs conclusions sont jugées irrecevables par de nombreux tribunaux. En l’espèce, nous avons une technologie testée avec très peu de contrôle et sans définition des responsabilités en cas d’erreur. De plus, la technologie de reconnaissance faciale et les algorithmes peuvent contenir, de façon intentionnelle ou non, des préjugés raciaux douteux. Enfin, un tel détecteur de mensonge tiendrait-il compte des différences dans la communication interculturelle ?

Qu’est-ce que cela signifie ?

Souvent, pour des raisons culturelles, religieuses, ou de conditions psychologiques individuelles, les gens n’engagent aucun contact visuel avec un fonctionnaire ou un policier du sexe opposé. Cela ne signifie pas pour autant d’entrée qu’ils ne disent pas la vérité. En outre, que se passe-t-il pour des migrants dont la mémoire est affectée par une expérience traumatisante, ou bien lorsqu’ils ne racontent pas leur histoire de façon linéaire ? Comment un détecteur de mensonge peut-il gérer ce genre de situation ?

Les créateurs du programme ont expliqué que leur système se contentait de donner des avertissements et laissait les gardes-frontières prendre les décisions. Cependant, Adissu, cité dans votre rapport, affirme que “parce que nous sommes noirs, les gardes-frontières nous haïssent, et leurs ordinateurs aussi”.

Certes, en théorie, l’algorithme ne fait que prévenir, mais en pratique, comme nous le savons sur la base d’études, le cerveau humain est souvent enclin à croire que les décisions prises par un ordinateur sont plus objectives. Par conséquent, si un algorithme propose pour un contrôle un réfugié qui est déjà discriminé pour des motifs raciaux, il sera souvent automatiquement suspect de terrorisme et devra apporter la preuve du contraire.

Peut-on s’attendre à davantage de programmes de ce type ?

Après d’abondantes critiques, iBorderCtrl a été arrêté, mais cela ne veut pas dire que d’autres expériences similaires ne vont pas être menées. Le programme Avatar, qui repose également sur la “reconnaissance des émotions”, est actuellement testé en Roumanie et au Canada.

Qu’a changé le Covid-19 dans le contexte des technologies de surveillance ? A-t-il servi de prétexte pour restreindre les droits des réfugiés ?

Quand la pandémie a éclaté, j’ai pensé que des organisations comme Frontex allaient vouloir agir au nom de la protection de la santé publique et assurer une protection des frontières contre des menaces sanitaires. Je ne me suis pas trompée. Dans leurs communiqués publics, ils disent devoir empêcher la propagation de la pandémie. Évidemment, ils le font pour justifier des restrictions des droits de l’homme, déployer de nouvelles technologies et recevoir plus de financements.

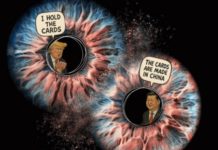

C’est une combinaison vraiment inquiétante, car historiquement les réfugiés et les migrants étaient vus comme ceux qui propageaient les maladies. Cette rhétorique problématique, faisant l’amalgame entre maladies et migration, a déjà été utilisée par le gouvernement hongrois ou l’administration de Donald Trump.

Quels ont été les autres effets de la pandémie ?

Elle a accéléré et normalisé l’emploi de nombreuses technologies de surveillance. Les militants et les chercheurs le redoutaient déjà en mars 2020, lorsque toutes ces solutions ont commencé à être massivement introduites comme remèdes, des robots détecteurs de coronavirus aux drones disant aux habitants de rester chez eux en passant par les applications de suivi de contacts.

C’est le technosolutionnisme – l’idée selon laquelle chaque problème, quel que soit son degré de complexité sociale, politique, ou encore économique, peut être résolu par la technologie, par exemple une simple application.

Pendant la pandémie, cette tendance s’est accélérée sans que nous débattions de ce que nous devrions automatiser et numériser, et de ce qui est trop sensible et subtil, par exemple le contrôle des frontières et les procédures de demande d’asile.

Pourquoi ?

Ces technologies nous touchent de façon totalement différente. Entre les migrants et nous, il existe une différence énorme en matière de droits. Par exemple, nous avons le choix de ne pas utiliser certaines solutions comme les applications de suivi de contacts sur téléphone. En revanche, un réfugié dans un camp en Europe, par exemple à Bruxelles, doit accepter un scan de la rétine pour recevoir à manger.

Pour être enregistré, et ensuite suivi.

De telles circonstances ne permettent pas un “consentement éclairé” comme celui que nous exprimons pour le traitement de nos données personnelles.

Dans votre rapport, vous citez Kaleb. À propos de ses contacts avec les technologies biométriques du camp où il se trouve, il dit qu’il se sent comme “un morceau de viande sans âme” dont on ne fait que scanner les empreintes digitales et les yeux.

Cela montre que la protection de la vie privée n’est qu’un des éléments du problème. Évidemment, elle est très importante, et la saisie de données par des gouvernements répressifs peut avoir des conséquences fatales. On le voit en Afghanistan, où des équipements biométriques laissés par les Américains se sont retrouvés entre les mains des talibans. Si ceux-ci parviennent à s’en servir pour identifier par exemple les défenseurs des droits de l’homme, ce sera une catastrophe.

Il ne faut donc en aucun cas négliger la protection de la vie privée, mais nous devons aussi avoir une perspective plus large sur la façon dont les technologies déshumanisent et affectent la dignité humaine. Nous devons également prendre en compte la complexité de l’expérience humaine et les raisons qui poussent quelqu’un à émigrer ou à demander l’asile.

Au nom de la santé publique et de la sécurité nationale, nous mettons aujourd’hui en place davantage d’outils de suivi et de contrôle : biométrie, caméras, drones, technologies de reconnaissance faciale, aussi utilisées contre des enfants. Nous militarisons les frontières et enfermons des gens dans des camps au lieu de nous concentrer sur ce qui arrête réellement la propagation de la pandémie.

C’est-à-dire ?

La redistribution des ressources, l’offre aux migrants de conditions de vie dignes et d’un accès aux soins. Si nous devons utiliser les technologies avant tout pour tenir les immigrants loin de nous et les surveiller, il me semble que nous avons fait une erreur quelque part.

On observe à côté de cela le renforcement du rôle d’entreprises privées qui se développent autour de la protection des frontières. Les gardes-frontières polonais utilisent des systèmes de la société israélienne Cellebrite pour accéder à des données stockées sur des téléphones. Il y a quelques années, Cellebrite les vendait ouvertement comme des outils utiles dans le cadre de l’examen des demandes d’asile.

Cela ne m’étonne pas du tout. Dans ce dispositif, les entreprises privées constituent un élément qui reste souvent caché. Or, depuis plusieurs années, une grande industrie se développe autour de la gestion des frontières, avec par exemple des producteurs de drones et de technologies de reconnaissance faciale.

L’un d’entre d’eux, Clearview AI, a signé l’an dernier un contrat avec le corps des gardes-frontières des États-Unis.

Les multinationales peuvent vendre de tels services aux États parce que le secteur public dépend pleinement du développement privé de technologies et n’a pratiquement pas de compétences en interne. Toutefois, le secteur privé a des priorités tout à fait différentes quand il conçoit de telles innovations, il se pose d’autres questions et est mû par la logique du profit. C’est pourquoi l’intelligence artificielle est développée pour détecter des mensonges et testée sur des réfugiés et des migrants, et pas par exemple pour détecter les racistes parmi les gardes-frontières.

Ce serait plus difficile à vendre.

Il existe également un problème juridique de responsabilité pour les technologies qui peuvent nuire à quelqu’un, par exemple en le discriminant. C’est confortable pour un État qui peut dire : nous n’avons pas conçu ce système défectueux, nous n’avons fait que le commander. De son côté, l’entreprise privée peut se couvrir sous le secret des affaires et le droit de la propriété intellectuelle pour ne pas permettre à des tiers de vérifier si son algorithme n’a effectivement pas un parti pris envers une minorité. Dans les faits, une personne négativement affectée par une “innovation” a très peu de possibilités de faire valoir ses droits.

Published by Courrier International